Was steckt hinter LLMs wie ChatGPT?

Hast Du Dich jemals gefragt, wie große Sprachmodelle wie ChatGPT oder Claude tatsächlich funktionieren? Dann bist Du nicht allein! Die Faszination für sogenannte Large Language Models (LLM) wächst rasant – und das zurecht. Diese Sprachmodelle bilden das Rückgrat moderner KI-Anwendungen und beeinflussen zunehmend, wie wir Informationen finden, kommunizieren und arbeiten.

In diesem Beitrag erklären wir, wie ein LLM funktioniert, was es mit dem Training solcher Modelle auf sich hat, welche Stärken und Schwächen bestehen – und warum diese Technologien die Zukunft der Kommunikation maßgeblich prägen werden. Grundlage dieser Erläuterung sind u.a. die fundierten Erklärungen von Andrej Karpathy, einem führenden KI-Forscher und Mitgestalter bei OpenAI, Tesla und Google.

Was ist ein Large Language Model (LLM)?

Ein Large Language Model ist ein KI-Modell, das mit riesigen Mengen an Textdaten trainiert wird, um menschliche Sprache zu verstehen, zu verarbeiten und selbst Texte zu generieren. Bekannte Beispiele für solche Modelle sind:

• ChatGPT (OpenAI)

• Gemini (Google DeepMind)

• Claude (Anthropic)

Diese Sprachmodelle erkennen Muster, grammatikalische Strukturen und semantische Bedeutungen. Sie „lernen“ Sprache, indem sie Milliarden von Textpassagen analysieren und daraus Regeln und Zusammenhänge ableiten. Ziel ist es, auf jede Texteingabe die statistisch wahrscheinlichste, relevante und kohärente Antwort zu generieren.

Das LLM als komprimiertes Wissensarchiv

Stärken und Schwächen von Large Language Models (LLM)

LLMs sind beeindruckend leistungsfähig – doch nicht unfehlbar. Karpathy nutzt die Metapher des Schweizer Käses: Das Modell ist in vielen Bereichen stark, enthält aber auch "Löcher", also unerwartete Schwächen.

Stärken

- Vielseitigkeit in Sprache und Stil

- Verarbeitung natürlicher Sprache (NLP) auf hohem Niveau

- Breites Allgemeinwissen (je nach Trainingszeitpunkt)

- Einsatz in zahlreichen Anwendungsbereichen: Content-Erstellung, Kundensupport, Datenanalyse

Schwächen

- Keine garantierte Faktentreue (Halluzinationen)

- Veraltete Informationen ohne Webzugang

- Fehlverhalten bei simplen Aufgaben

- Keine echte „Intelligenz“, sondern Wahrscheinlichkeitsberechnungen

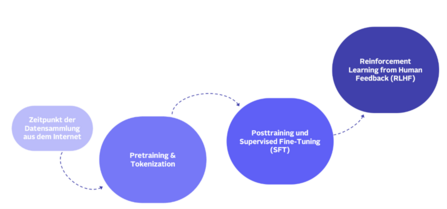

Wie entsteht ein Large Language Model (LLM)?

Phase 1: Pretraining und Tokenisierung

Reasoning-Fähigkeiten, die bereits im Pretraining und durch verschiedene Trainingsmethoden entwickelt werden, ermöglichen es einem LLM, logisch zu denken, Schlussfolgerungen zu ziehen und Probleme zu lösen. Diese Fähigkeiten erlauben es dem Modell auch, seinen eigenen Output zu analysieren und Verbesserungspotenziale zu erkennen.

Mein Tipp an euch: Wer mehr zum Training des Neural Networks lernen möchte, kann sich im Video „Deep Dive into LLMs like ChatGPT“ ab Minute 15 schlau machen.

Phase 2: Supervised Fine-Tuning (SFT)

Nach dem Pretraining folgt das Feintuning: Hier lernt das Modell anhand von menschenbewerteten Beispielen, wie es in realen Konversationen angemessen reagiert. Ziel ist es, relevante, sichere und korrekte Antworten zu liefern. Menschliche Annotatoren geben hier Feedback – ein elementarer Bestandteil im Training.

Phase 3: Reinforcement Learning from Human Feedback (RLHF)

In der finalen Phase wird das Modell mit menschlichem Feedback weiter verbessert. Es lernt, auf gute Antworten mit Belohnung zu reagieren und schlechte zu vermeiden.

RLHF ist heute einer der entscheidenden Gründe für die Qualität aktueller LLMs.

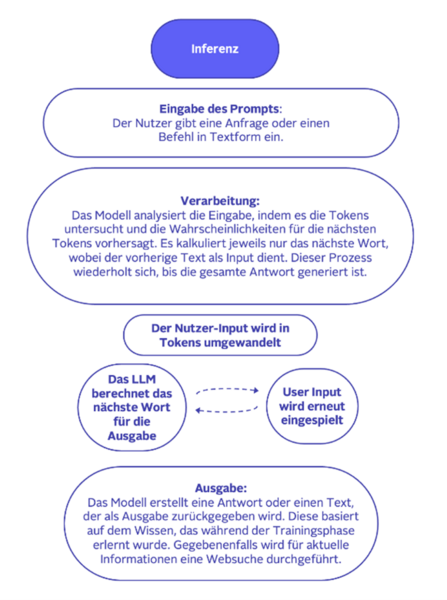

So funktioniert die Inferenz eines Sprachmodells

Die Inferenz bezeichnet den Moment, in dem ein fertig trainiertes Modell auf neue Eingaben reagiert:

Das Modell „denkt“ dabei nicht wie ein Mensch, sondern folgt Wahrscheinlichkeitsmustern, die es im Training gelernt hat.

Fazit: Die Zukunft der Sprachmodelle

Large Language Models (LLM) wie ChatGPT oder Gemini stehen am Beginn einer neuen Ära der Mensch-Maschine-Interaktion. Ihre multimodalen Fähigkeiten, die Integration von Bild, Text, Ton und Video, sowie tägliches Feedback durch Nutzer machen sie jeden Tag leistungsfähiger.

Die Einsatzmöglichkeiten sind nahezu unbegrenzt: von personalisierten Assistenten über automatisierte Textgenerierung bis hin zu datenbasierten Geschäftsentscheidungen.

Wer heute versteht, wie ein LLM funktioniert, ist morgen besser gerüstet – sei es als Content Creator, Entwickler oder Entscheider im digitalen Wandel. Ich hoffe, dieser Beitrag hat dir geholfen, ein besseres Verständnis dafür zu gewinnen, wie Large Language Models (LLM) wie ChatGPT funktionieren! :-)

FAQ zu Large Language Models (LLM)

Was bedeutet LLM?

LLM steht für Large Language Model, ein großes Sprachmodell zur Verarbeitung natürlicher Sprache mithilfe von KI.

Wie lernt ein Sprachmodell?

Durch Pretraining mit Milliarden von Textdaten, Feintuning durch Menschen und Reinforcement Learning mit Feedback.

Sind LLMs intelligent?

Nein – sie simulieren Intelligenz auf Basis von Wahrscheinlichkeiten, verfügen aber nicht über echtes Bewusstsein.

Welche LLMs gibt es?

Beispiele sind ChatGPT, Gemini, Claude, LLaMA, Mistral und viele mehr.

Wie aktuell sind die Informationen eines LLMs?

Die Aktualität der Informationen eines LLMs ist durch den Zeitpunkt des letzten Trainings begrenzt - das ist der sogenannte "Knowledge Cutoff". Einige LLMs können zusätzlich auf aktuelle Informationen zugreifen (z.B. durch Websearch oder Datenbankabfragen), aber das LLM selbst enthält nur Wissen bis zu seinem letzten Training. Diese externen Informationsquellen sind dabei nicht Teil des eigentlichen Modells.

Möchtest du Teil des Teams werden?

0Noch keine Kommentare

Geschrieben von

Ähnliche Beiträge

Aemilia und Svenja15.01.2026

Aemilia und Svenja15.01.2026Datengetriebene Teamentwicklung: Wie OTTO Tech-Teams zum Erfolg führt

134Was macht Tech-Teams wirklich wirksam? Wie wir mit datengetriebener Teamentwicklung Effektivität messbar machen. ➡️ Jetzt lesenData ScienceArbeitsmethoden- Team Jarvis17.12.2025

Learning to Rank ist Rocket Science: Wie Clojure unser Machine Learning mit Deep Neural Networks beschleunigt

312Erfahre, wie OTTO mit 🖥️ Clojure robuste Machine Learning Pipelines für Learning to Rank baut 🚀 und so das Sucherlebnis verbessert.DevelopmentMachine Learning